Loss

L1 / L2

1. L1 Loss(绝对值损失,Mean Absolute Error, MAE)

L1 Loss 计算的是预测值和真实值之间的绝对差值之和

\[L_1 = \frac{1}{N} \sum_{i=1}^N |y_i - \hat{y}_i|\]- 梯度不连续:

- 在 $y_i - \hat{y}_i = 0$ 时,梯度不可导(通常用 0 近似)

- 这可能会导致在模型优化时收敛速度较慢

2. L2 Loss(平方损失,Mean Squared Error, MSE)

L2 Loss 计算的是预测值和真实值之间的误差的平方和

\[L_2 = \frac{1}{N} \sum_{i=1}^N (y_i - \hat{y}_i)^2\]对比

| 特性 | L1 Loss | L2 Loss |

|---|---|---|

| 对异常值的影响 | 鲁棒,不易受异常值影响 | 敏感,异常值会导致较大惩罚 |

| 梯度性质 | 不连续,收敛慢 | 平滑,收敛快 |

| 用途 | 需要对异常值鲁棒 | 需要对误差敏感,拟合更精确 |

| 优化结果 | 倾向于稀疏解 | 倾向于均匀解 |

Smooth L1 Loss

用于回归任务中,常常用来平衡对小误差和大误差的敏感性。它的设计目标是结合 L2 损失(对小误差更敏感)和 L1 损失(对大误差更稳定)的优点,同时避免 L2 损失对异常值(outliers)的过度敏感

\[\text{Smooth L1}(x) =\begin{cases} 0.5 \cdot x^2, & \text{if } |x| < \delta \\\delta \cdot (|x| - 0.5 \cdot \delta), & \text{if } |x| \geq \delta\end{cases}\]- x 是预测值和目标值之间的差异

- $\delta$ 是一个可调节的阈值(超参数). 当 $\delta = 1$ 时, 是一个常见的默认值.

Smooth L1 Loss 的特点:

- 当误差 $∣x∣$ 很小时,使用二次损失 $0.5x^2$,类似于 L2 Loss,对小误差惩罚更大

- 当误差 $∣x∣$ 很大时,使用线性损失 $\delta \cdot (abs(x) - 0.5 \delta)$,类似于 L1 Loss,对大误差的惩罚较轻,减轻了异常值的影响

为什么 Smooth L1 Loss 有用?

- 对异常值鲁棒:

- L2 损失(如 MSE)在误差很大时会平方,惩罚很重,因此容易被异常值主导

- L1 损失(如 MAE)对误差采取线性惩罚,对异常值较稳定,但对小误差敏感性不足

- Smooth L1 Loss 在 $∣x∣$ 小时采用二次形式,有较高的灵敏度,而在 $∣x∣$ 大时转为线性形式,减小异常值的影响

- 平滑性:

- 相比于 L1 损失(在 $∣x∣=0$ 处不可导),Smooth L1 Loss 在整个区间上是连续且可导的,因此在优化过程中更加平滑,有利于模型收敛

- 平衡性:

- 结合了 L1 和 L2 的优点,适用于需要在异常值和小误差之间找到平衡的场景

MLE / MAP

MAP(Maximum A Posteriori, 最大后验估计) 和 MLE(Maximum Likelihood Estimation, 最大似然估计) 是两种常见的统计方法, 用于参数估计

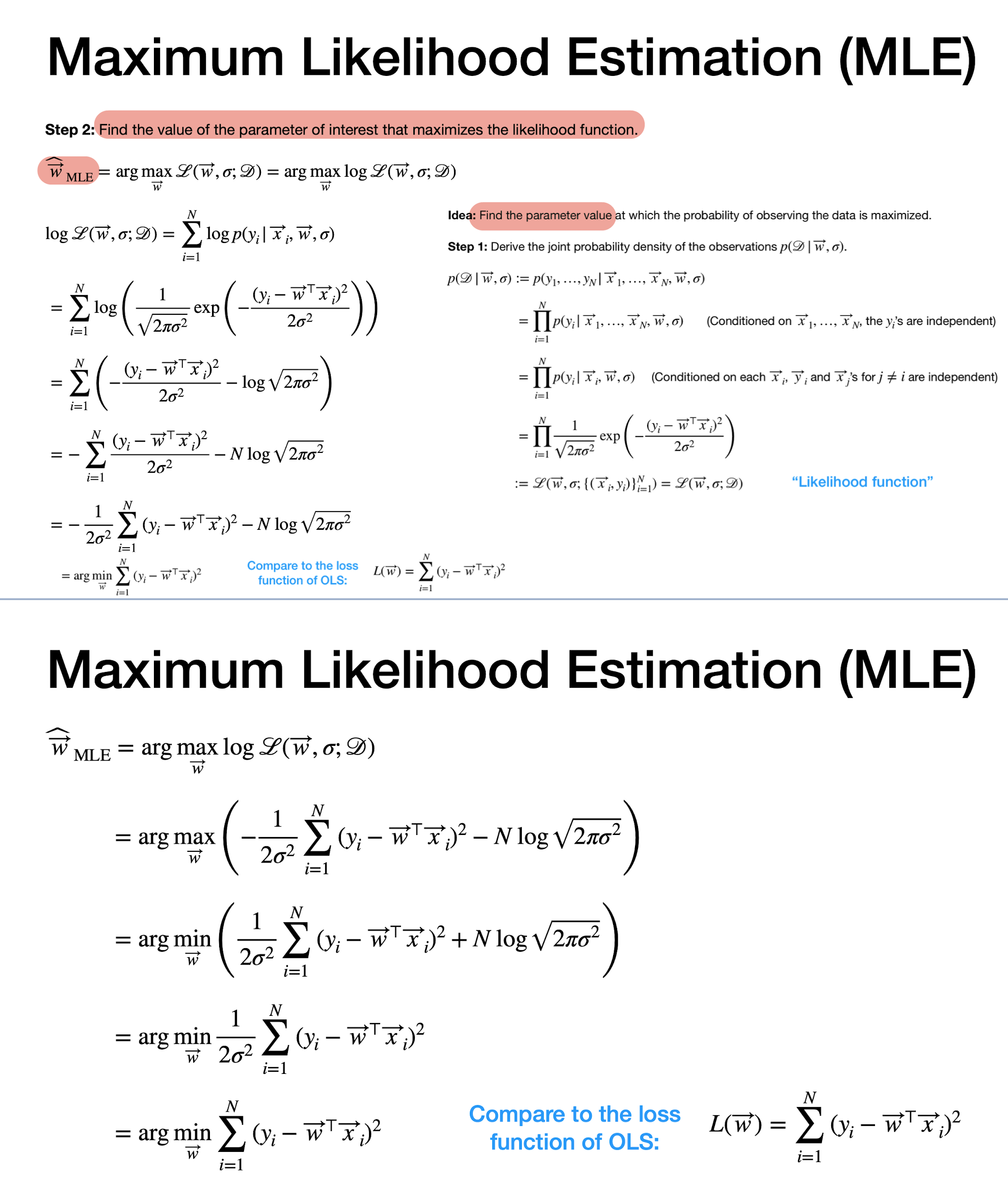

1. 最大似然估计(MLE)

MLE 的目标是找到参数 θ\thetaθ 使得在这些参数下, 观测数据的似然函数 \(P(X\|\theta)\) 最大化

\[\hat{\theta}_{\text{MLE}} = \arg\max_\theta P(X|\theta)\]- X: 观测数据

- $\theta$: 模型的参数

核心思想:

MLE 只基于观测数据 X, 不考虑参数的先验知识. 它寻找的参数是最可能生成这些观测数据的参数

步骤:

-

写出观测数据的似然函数 $$P(X \theta)$$ -

取对数得到对数似然函数 $$\log P(X \theta)$$(通常更易处理) - 对 θ 求导并取极值,得到参数估计 \(\hat{\theta}_{\text{MLE}}\)

特点:

- 优势:直观且依赖数据,无需假设先验分布。

- 劣势:对数据量敏感,当数据不足时,可能会导致不稳定的估计。

- 常用场景:MLE 广泛用于回归模型、分类模型等的参数估计。

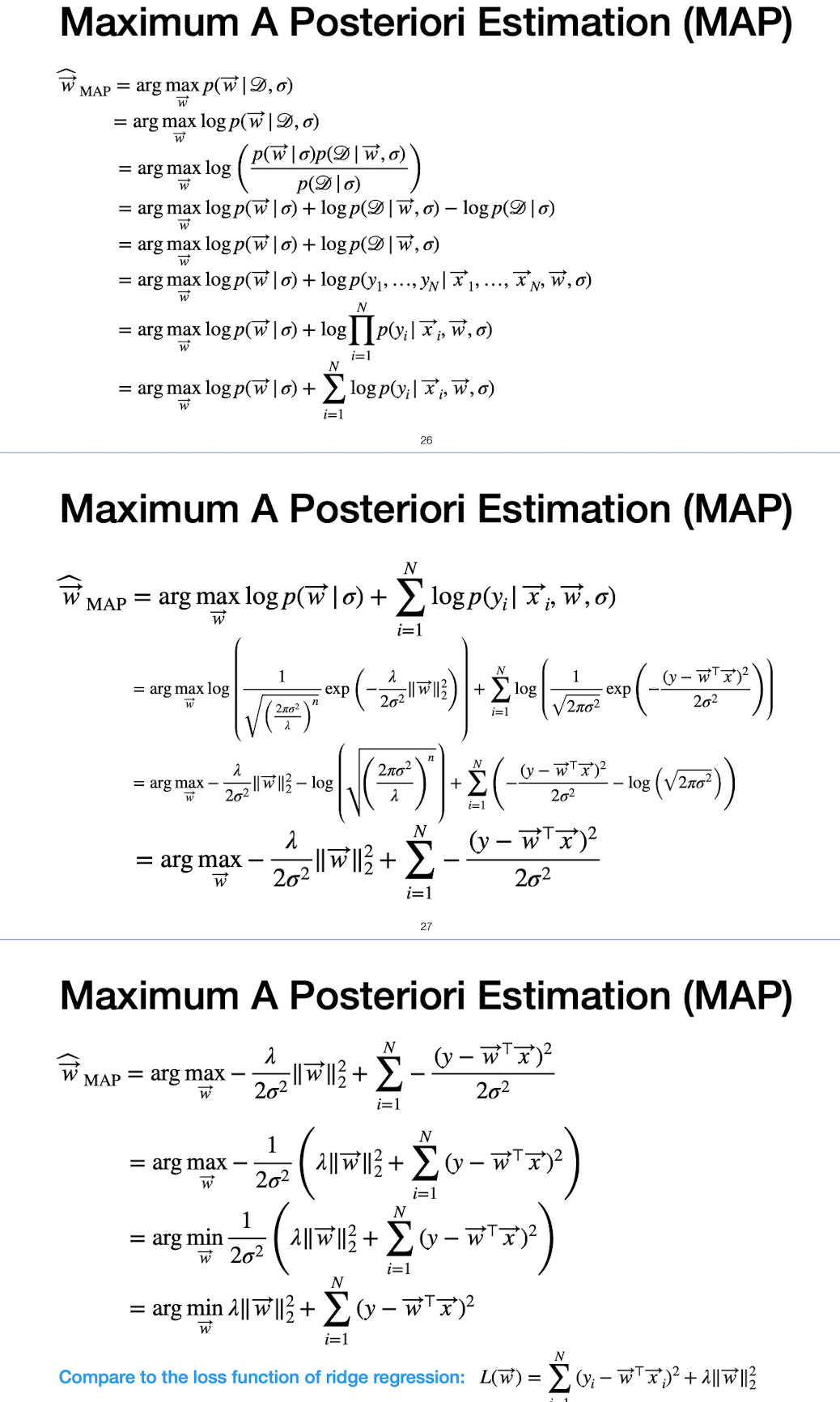

2. 最大后验估计(MAP)

MAP 的目标是找到参数 $\theta$ 使得给定观测数据 X 的后验概率 \(P(\theta\|X)\) 最大化。公式如下:

\[\hat{\theta}_{\text{MAP}} = \arg\max_\theta P(\theta|X)\]根据贝叶斯公式:

\[P(\theta|X) = \frac{P(X|\theta)P(\theta)}{P(X)}\]因为 P(X) 与 $\theta$ 无关,简化为:

\[\hat{\theta}_{\text{MAP}} = \arg\max_\theta P(X|\theta)P(\theta)\]-

$P(X \theta)$: 似然函数(数据对参数的支持)。 - $P(\theta)$: 参数的先验分布(反映对参数的已有知识)。

核心思想:

MAP 不仅依赖观测数据,还结合了对参数的先验知识 $P(\theta)$。它通过综合观测数据和先验分布来估计参数。

特点:

- 优势:适用于数据稀少或不确定性较高的场景,通过先验分布提高估计的稳定性。

- 劣势:先验分布可能需要人为假设,不一定准确。

- 常用场景:在贝叶斯统计中,MAP 是核心方法,广泛用于贝叶斯分类器、生成模型等。

Enjoy Reading This Article?

Here are some more articles you might like to read next: